Geschrieben von everflux am Juni 7th, 2007

Besser als Sex 😉

Ich habe den Resin J2EE Server getestet und stolperte dabei über einen (eigentlich kleinen) Bug, der mich fast verzweifeln ließ.

Dank der Hilfe von Stefan konnte das jedoch schnell als Kombination von „Bug“ und „falsche URL aufgerufen“ identifiziert werden. Als braver OpenSourceler hab ich dazu einen Bug bei Caucho eingestellt und eine halbe Stunde später war die Sache bereits erledigt.

Wow.

Geschrieben von everflux am Juni 5th, 2007

Google (einer der größten Suchmaschinenanbieter und auch als Datenkrake bekannt) schlampt wohl etwas mit der Sicherheit.

Ich habe zwar keine Ahnung, wie die Leute auf sowas kommen, aber offenbar hat Google selber geholfen eine ungesicherte Stelle bei Google aufzudecken. Wie Google-Blogoscoped berichtet, wurde im Google Index (der Suchmaschine) die URL eines Google-Dienstes gefunden, der nicht gut abgesichert war.

Ursprünglich hat Earl Grey über die Directory-Listing bzw. Directory-Traversal Lücke gebloggt, doch waren die Informationen sehr dürftig. Die Hacker Seite 0x00000 hat sich der Sache dann angenommen und stell ausführlichere Informationen zur Verfügung.

Die Lücke ist nichts weltbewegendes – man kann einfach denvon Google verwendeten Webserver dazu bewegen mehr Daten herzugeben als nur die vorgesehende von Google programmierte Oberfläche.

So kann man sehen, mit welchen Userdaten der Google-Dienst auf die (MySQL) Datenbank zugreift, und es lassen sich auch einzelne serverseitige Java Dateien herunterladen.

Inzwischen ist die Lücke wohl gestopft, sprich man erreicht unter dieser URL keine internen Daten von Google mehr.

Sollte es sich bei der ganzen Angelegenheit nicht um einen Fake oder Linkbait handeln, wovon ich mal ausgehe, dann macht das zumindest nachdenklich, wie ernst es Google mit der Sicherheit hält. Nachdem bereits einige offizielle Google-Blogs mit falschen Postings bestückt wurden, ist dies ein weiteres Indiz dafür, dass drigender Nachholbedarf bei dem Thema Sicherheit besteht.

Und das fängt bei ganz kleinen Dingen an, wie nicht benötigte Ports (in diesem Fall war es 8882) per Firewall dicht zu machen, und Passwörter mit höherer Sicherheit als „k00k00“ zu verwenden. Mal davon ganz zu schweigen, dass Passwörter nicht in prinzipiell von außen abrufbare Verzeichnisse gehören.

Geschrieben von everflux am Juni 4th, 2007

Das ist doch mal ein hammer guter Zug: Ich

schnapp mir einfach eine Domain, die mal für ein Projekt der

Bundesregierung gedient hat.

Vielleicht ist es auch nur eine Fehlkonfiguration oder ein Versehen

– man kann ja nie wissen, aber interessant ist es allemal, das

scheinbar genau das hier passiert ist:

http://www.gnupp.de/

der Verweis auf „sicherheit-im-internet“, dem Projekt des

Bundesministeriums für Wirtschaft und Arbeit (BMWA) und des

Bundesministeriums des Innern (BMI).

Nur lauscht auf der Domain inzwischen eine Firma, die Sicherheitslösungen anbietet. Und auch Internetdienstleistungen.

Mit Sicherheit gibts noch weitere Links darauf aus den Zeiten als das Projekt aktiv lief.

Google liefert es denn auch als einen der ersten Treffer bei der Anfrage „sicherheit im Internet“ – als Snippet erscheint (noch) „Ein Informationsdienst des Wirtschaftsministeriums, des Innenministeriums und des BSI zum Thema ‚Sicherheit im Internet‚ mit aufbereiteten Einführungen, …“

Na denn.

Geschrieben von everflux am Juni 4th, 2007

Das ist ja mal ein heißes Feature 🙂

Eigentlich wollte ich in dem Feed eines Blogs stöbern und war gerade zu faul die URL in meinen Bookmarks zu suchen. Also schwupps Google aufgemacht und da fällt mir ein neuer Aktionslink ins Auge: Neben „im Cache“ und „ähnliche Seiten“ kann ich mir jetzt noch „Notieren“ anwählen.

Wie kommts dazu?

Ich hatte mich vorher bei Google angemeldet um Analytics Daten anzuschauen. Und somit kann ich von den erweiterten Funktionen der personalisierten Suche profitieren.

Was ein Komfort!

Und das gibts im Tausch für das bißchen Privatsspähre…

Geschrieben von everflux am Juni 1st, 2007

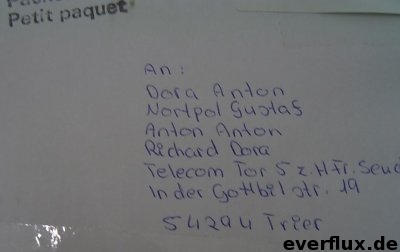

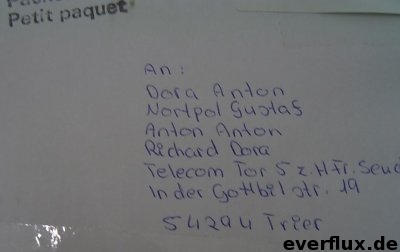

Um ganz sicher zu gehen, dass ein Paket korrekt an die Firma „Dangaard“ addressiert wird, wurde während eines Telefonates die Addresse buchstabiert.

Das Paket kam an.

Trotz der Addressierung.

Geschrieben von everflux am Juni 1st, 2007

Wieder einmal mußte ich feststellen, dass es „da draußen“ ziemlich asoziale Bot(betreiber) gibt. Heute hat id-search.org einen meiner Server ziemlich in die Knie gezwungen, um ein PhpBB Forum abzusaugen.

Dabei kamen bis zu zehn Anfragen pro Sekunde auf dem Server runter – robots.txt wurde „natürlich“ total ignoriert.

500 MB (reines HTML!) wurde auf diese Weise in kürzester Zeit abgesaugt.

Immerhin hat sich der bot identifiziert. Ich empfehle anderen möglicherweise Betroffenen den IP Block 74.52.0.0/15 und 66.90.64.0/18 zu sperrren. Der User-Agent ist

Mozilla/5.0 (compatible; IDBot/1.0; +http://www.id-search.org/bot.html

Man möchte garnicht wissen, wie es nach Version 1.0 mit dem Ding weiter geht.

Geschrieben von everflux am Mai 31st, 2007

Um dem Aufkommen von SPAM endlich machtvoll gegenüber zu treten hatte ich Greylisting als Heiligen Gral eingeordnet, hatte es mich doch in den letzten Monaten unglaublich gut vor den ganzen Spam – äh – Verbraucherinformationsmails geschützt.

Die Idee dabei ist ziemlich simpel: Die meisten Spammer verwenden Botnetze um ihren Müll abzukippen. Klappt die Zustellung einer Mail nicht, so wird in der Regel auch abgebrochen.

Und wenn es nochmal versucht wird, dann von einem anderen gehackten Rechner des Botnet, aber in der Regel nicht nochmal von dem selben Spam-Droid, da dafür eine Menge Daten gespeichert und verwaltet werden müssen, was die mögliche Spam-Menge doch stark eingrenzt.

Doch seit einigen Tagen läuft bei mir relativ viel Pump-and-Dump Aktienspam bzw. Stockspam auf. Ein Blick in die Header sieht dann meistens so aus:

Delivered-To: [email protected]

X-Greylist: delayed 600 seconds by postgrey-1.27 at keltix; Thu, 31 May 2007 12:59:23 CEST

Received: from mail.detalita.lt (mail.detalita.lt [195.14.166.35])

by keltix.sforce.org (Postfix) with SMTP id 8D65FA30A1

for <[email protected]>; Thu, 31 May 2007 12:59:23 +0200 (CEST)

Received: from [159.119.156.127] (helo=vpczo)

by mail.detalita.lt with smtp (Exim 4.62 (FreeBSD))

id 1IiQ6-H9; Thu, 31 May 2007 14:02:18 +0300

Message-ID: <002f0$7f9c779f@vpczo>

Auffällig dabei ist, dass das delay in der Regel bei 600 Sekunden liegt – mindestens ein Botnet ist also mit einem anti-greylisting ausgestattet.

Offenbar haben viele 10 Minuten eingestellt und am default Wert auch nichts geändert, und das macht sich so ein Spammer zu Nutze.

Jetzt könnte ich natürlich anfangen mit dem delay zu experimentieren – jedoch wird dann die Erstzustellung einer E-Mail ganz schön verzögert, 10 Minuten als Minimum finde ich ja noch tragbar. Darüber hinaus… puh.

Die Monokultur ist weiterhin der beste Angriffsvektor für Parasiten und Schädlinge.

Geschrieben von everflux am Mai 31st, 2007

Seit einigen Tagen rollt eine der größten Spam-Lawinen die ich seit langem gesehen habe. Neben dem üblichen pump-and-dump Aktienspam ist jedoch etwas dabei, was mich hellhörig macht.

Es geht um laester-check.com – als Absender habe ich www.immeraktuell.com und ein Mädchen erklärt mir ausführlich wie schlimm das doch mit dem Lästern ist. Das einzige was gegen die Lästerei hilft – ganz klar – ist das Läster Check Tool für ICQ.

Jeder halbwegs mit Hirn ausgestattete Mensch wird sofort merken, daß das Tool eigentlich garnicht funktionieren kann, denn angeblich bekomme ich meinen Download-Link wenn ich per ICQ das Tool an einen Haufen weiterer User empfohlen habe. Dabei wird suggeriert die Macher könnten ICQ Nachrichten lesen und auf die Empfehlung hin überprüfen.

Wie auch it guerilla in seinem Blogeintrag schreibt, kann das Tool entweder garnicht funktionieren, oder ist ein Trojaner der ICQ Nachrichten an die laester-check Jungs übermittelt. Zwecks oeberprüfung.

Der einzige Sinn kann eigentlich nur in den beiden Punkten bestehen den Usern Software unterzujubeln ( -> Trojaner zum Spammen und co) und verifizierte ICQ Nummern zu sammeln. (Möge der Spam im ICQ Netzwerk nie versiegen)

Hier noch der Spamtext für alle die mitlesen wollen:

Hey ... :)

Schau mal was ich hier witziges gefunden habe:

www.laester-check.com

Ist super klasse und funktioniert auf alle möglichen Begriffe. Bin schon den ganzen tag am rumprobieren

:) Es ist echt so krass wie manche Leute über uns abziehen :( aber jetzt weiß ich auch, von wem das alles kommt und das wird ein Ende haben.

Musst du echt mal testen und mir mal bescheid geben ob es auch bei dir funktioniert. :P musste allerdings den Link an 16 weiter schicken ... oder ich hab mich verzählt ... hmmm

Okay dann bis demnächst und meld dich mal.

Ciao Steffi

Wenn Sie sich abmelden möchten benutzen Sie bitte folgenden Link: http://www.immeraktuell.com/u?id=suckr oder senden Sie eine leere E-Mail an den Empfänger: [email protected]

Geschrieben von everflux am Mai 31st, 2007

Ein lokaler Anbieter von oebernachtungsdienstleistungen möchte gerne Touren durch die Stadt anbieten. Dabei werden neue Wege beschritten: Eine Gruppe von Studenten hat den Auftrag bekommen einen Geocache auszuklügeln, bei dem wichtige Sehenswürdigkeiten berücksichtigt werden.

Die ungeführte Stadtführung der Zukunft? Auf jeden Fall eine interessante Idee, und für Studenten eine nicht unlukrative Einnahmequelle.

Erinnert ein wenig an die verschiedenen OpenSource Geschäftsmodelle, bei denen Produkte für die Allgemeinheit gesponsert werden.

Geschrieben von everflux am Mai 28th, 2007

Vermutlich genauso oft, wie sich Menschen den Kopf zerbrechen, wie sie ihre Webseite bei Google möglichst gut platzieren, stellt sich manchen die Frage: Verdammt, wie kriege ich diese Daten bei Google wieder raus?

Vor allem wenn es um persönliche Informationen geht, kann es da schon manchmal richtig stressig werden.

Besonders ärgerlich: Selbst wenn man den Seitenbetreiber erreicht hat, oder sonstwie veranlassen konnte, daß die unerwünschten Inhalte auf der eigentlichen Seite verschwunden sind, hat Google diese manchmal noch Wochen oder Monate lang in den Suchergebnissen oder gar im Google-Cache.

Genau in dieser Sitution kann aber nun Abhilfe geschaffen werden. Wenn die ursprünglichen Webseiten entfernt worden sind (also ein 404 oder 410 Fehler gemeldet wird, bzw. die Seiten per robots.txt nun gesperrt sind) kann auch jemand anderes als der Webseitenbetreiber bei Google um die Entfernung aus der Google Suchmaschine bitten: Dazu geht man auf das Webpage removal tool von Google und loggt sich dort mit einem Google Account ein. Anschließen kann man die URLs für Google markieren. Google prüft dann natürlich ob die Seiten wirklich auch vom Webmaster gelöscht wurden, ehe die Daten aus Google entfernt werden, sonst könnte ja jeder andere Seiten kicken. Sicherlich nicht im Sinne des Erfinders.

Neue Kommentare