Seit Monaten schon stapelt sich der Müll: Spam der Schwerlastregale, Erste-Hilfe-Koffer und weiteres Zeugs bewirbt, den man total komfortabel und günstig einkaufen kann. Alles weit unter dem Listenpreis!

Die Webseiten haben unterschiedliche Domains, bei einigen habe ich mal geschaut, diese hatten dann ein Frame, dass auf www.handelskauf.com zielt.

Vom Design her sind die Seiten schlicht bis altbacken.

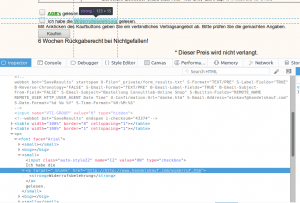

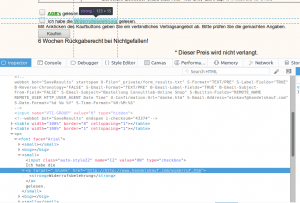

Von gesicherter Verbindung – eigentlich Standard bei der Verarbeitung potentiell personenbezogener Daten – keine Spur. Direkt auf der Startseite springt einem ein dicker Disclaimer entgegen:

Sollten Sie unverlangt E-Mails erhalten haben (Joe-Job), die auf uns als Absender hinweisen, distanzieren wir uns ausdrücklich von diesen Schreiben. Bisher wurde anhand der Absender-IP-Informationen festgestellt, dass Schreiben mit gefälschten Absendern in unserem Namen aus Russland und China versandt wurden. Gleichzeitig bitten wir Sie, uns hier zu informieren, damit wir erforderliche Schritte einleiten können um eine zukünftige Belästigung zu verhindern. Vielen Dank!

Der Link ist kein Formular, sondern die E-Mail Adresse [email protected] – hier würde ich auf keinen Fall etwas hinmailen, denn nichts finden potentielle Spammer besser, als verifizierte Adressen. Ich sage daher potentielle Spammer, da mein Gesamteindruck der E-Mails und der Webseite der ist, dass der Anbieter tatsächlich der Versender der E-Mails ist. Alles andere – Joe-Job – halte ich für eine nicht plausible Schutzbehauptung.

Wenn man genug sucht – ein Impressum ist nicht zu finden – findet man vergraben in den AGB dann „Consulttrayx, Kruppstr. 2, 60388 Frankfurt. mail: [email protected]“ als angeblichen Anbieter.

Auf der Webseite ist eine Faxnummer angegeben: Telefax 069-25577137 Consulttrayx

Schaut man sich die Daten des Domaininhabers an, so sieht man

Updated Date: 2016-09-05T13:37:47.0Z

Creation Date: 2016-09-05T13:37:47.0Z

Registrar Registration Expiration Date: 2017-09-05T13:37:47.0Z

Registrar: Key-Systems GmbH

Registrar IANA ID: 269

Registrar Abuse Contact Email: [email protected]

Registrar Abuse Contact Phone: +49.68949396850

Domain Status: ok https://icann.org/epp#ok

Registry Registrant ID: Not Available From Registry

Registrant Name: Markus Böhme

Registrant Organization: Palex GmbH

Registrant Street: Sternplatz 3

Registrant City: Freudenberg

Registrant State/Province: Hessen

Registrant Postal Code: 97896

Registrant Country: DE

Registrant Phone: +49.6925577137

Registrant Phone Ext:

Registrant Fax:

Registrant Fax Ext:

Registrant Email: [email protected]

Die Palex GmbH, palex.eu hat auf der Webseite stehen

Palex GmbH

Sternplatz 3

97896 Freudenberg

Telefon: 0800-7243267 (Freecall)

Telefax: 06181-5709487

Ustr.-Nr. DE279949400

EORI-Nr. DE58871984157027

AG Mannheim HRB 723633

Geschäftsführer: M. Böhme

Interessant ist hier die gekürzte Angabe des Namens Markus Böhme – dies kann als rechtswidrig bezeichnet werden, denn es gibt die Vorgabe den vollständigen Namen des Geschäftsführers im Impressum anzugeben. Sucht man nach der Umsatzsteuernummer DE279949400 so findet man haufenweise Berichte über Spam von der „Mbi Gmbh“, auch hier ist der Geschäftsführer Markus Böhme.

Da muss jemand aber wirklich wirklich Pech haben immer diese Joe-Jobs abzubekommen… und da macht man schon ständig neue GmbHs… mit der selben Umsatzsteueridentifizkationsnummer?

Auch super ist die Verlinkung der Widerrufsbelehrung, wenn man verrückt genug ist bei einem so unseriösen Laden ohne Impressum zu bestellen: Der Link funktioniert schlicht nicht.

Was könnte der Grund sein für so einen offensichtlichen Spam mit einem Shop, in dem keiner bestellt, der bei Trost ist?

Validierungs von E-Mail Adressen?

Eine Seite mit der man Malware vertreiben kann?

Oder gibt es tatsächlich Leute, die auf so etwas anspringen und kaufen?

Bei Beschwerden würde ich in jedem Fall die kostenlose Rufnummer 0800-7243267 wählen und nicht dort hin mailen. Sonst ist noch mehr Spam von dem Herrn Böhme oder einer der verbundenen Firmen wie der Consulttrayx Spam wahrscheinlich.

Was kann man tun? Ich würde empfehlen sich bei dem jeweiligen Anbieter der genutzten Infrastruktur zu beschweren. OMCnet Internet Service GmbH bietet für handelskauf.com und palex.eu die Infrastruktur.

Hier könnte ein Hinweis an Lutz Rabing, den Geschäftsführer der OMCnet für Sensibilität sorgen.

Neue Kommentare